Now Reading: OpenAI lansează control parental pentru ChatGPT după un caz tragic în SUA

-

01

OpenAI lansează control parental pentru ChatGPT după un caz tragic în SUA

OpenAI lansează control parental pentru ChatGPT după un caz tragic în SUA

OpenAI a anunţat lansarea unui sistem de control parental pentru ChatGPT, ca răspuns la un scandal major din Statele Unite. Decizia vine după ce părinţii unui adolescent californian de 16 ani, care s-a sinucis, au acuzat compania că AI-ul ar fi furnizat fiului lor instrucţiuni detaliate pentru a-şi pune capăt zilelor. Plângerea lor a declanşat dezbateri aprinse privind responsabilitatea dezvoltatorilor de inteligenţă artificială şi riscurile pentru utilizatorii tineri.

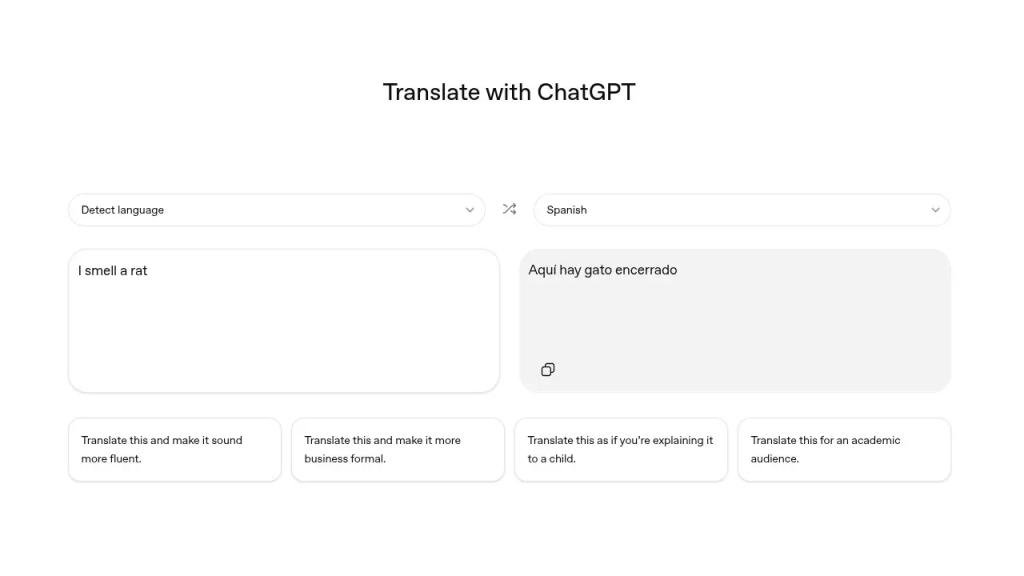

Noul sistem va permite părinţilor să conecteze contul copilului la propriul cont şi să stabilească reguli clare privind interacţiunea cu ChatGPT. Opţiunile includ limite de timp, restricţii pe subiecte sensibile şi personalizarea tonului răspunsurilor generate de AI. În plus, va exista un mecanism de alertă: dacă modelul detectează semne de suferinţă acută, părinţii vor fi notificaţi imediat, putând interveni rapid şi prevenind escaladarea situaţiei.

OpenAI a subliniat că scopul nu este doar protecţia, ci şi prevenţia, oferind părinţilor şansa de a observa semnale care altfel ar putea trece neobservate. Parametrii conturilor minorilor vor putea fi ajustaţi fin, astfel încât interacţiunile să fie adaptate la nevoile şi vulnerabilităţile fiecărui adolescent.

Anunţul a fost făcut la doar o zi după ce cazul adolescentului a intrat în atenţia publică, readucând în prim-plan întrebarea: poate inteligenţa artificială influenţa decizii extreme şi cine răspunde pentru consecinţe? Specialiştii în sănătate mintală consideră incidentul un semnal de alarmă, arătând vulnerabilitatea tinerilor în faţa răspunsurilor algoritmilor, care nu pot înţelege pe deplin complexitatea unei crize personale.

OpenAI a recunoscut necesitatea de a îmbunătăţi modul în care modelele detectează şi gestionează situaţiile de criză, iar sistemul AI va fi antrenat pentru a redirecţiona conversaţiile care indică suferinţă psihologică. În următoarele 120 de zile, compania va implementa şi alte măsuri, inclusiv redirecţionarea discuţiilor sensibile către modele mai avansate, cum ar fi GPT-5 Thinking, care aplică directive de securitate mai stricte.

Compania a subliniat că schimbările nu reprezintă doar o reacţie punctuală, ci fac parte dintr-un proces pe termen lung pentru a asigura siguranţa utilizatorilor tineri. În paralel, plângerea părinţilor poate crea un precedent juridic privind responsabilitatea companiilor AI, iar dezbaterea se extinde dincolo de tehnic în sfera eticii: cât de mult ar trebui să intervină un algoritm şi unde începe controlul excesiv?

Introducerea controlului parental marchează un pas important în integrarea AI în viaţa de zi cu zi. Pentru adulţi, ChatGPT rămâne un instrument util, dar pentru tineri poate fi periculos fără supraveghere. Noile măsuri caută să echilibreze libertatea de explorare cu siguranţa emoţională.

Cazul tragic din California arată însă că responsabilitatea nu poate reveni doar companiilor: părinţii, profesorii şi societatea trebuie să rămână activ implicaţi în modul în care tinerii folosesc tehnologia. Într-o lume tot mai digitalizată, protecţia sănătăţii mintale a adolescenţilor devine o prioritate care nu poate fi ignorată.