Now Reading: Pericolul psihozelor induse de AI: o nouă criză ignorată de industria tech

-

01

Pericolul psihozelor induse de AI: o nouă criză ignorată de industria tech

Pericolul psihozelor induse de AI: o nouă criză ignorată de industria tech

Fenomenul cunoscut sub numele de „ChatGPT psychosis” începe să atragă atenţia tot mai multor experţi din tehnologie. Ceea ce iniţial părea un caz izolat a devenit un semnal de alarmă tot mai grav: unii utilizatori dezvoltă bucle mentale periculoase în urma interacţiunilor cu inteligenţa artificială, ajungând la teorii conspiraţioniste, realităţi paralele şi concluzii extreme, uneori chiar fatale. Au fost documentate cazuri care includ episoade psihotice, internări forţate, pierderea locuinţei şi chiar sinucideri.

Un moment decisiv a fost marcat de declaraţiile publice ale lui Geoff Lewis, un investitor important şi susţinător vocal al AI-ului, care a afirmat pe reţelele sociale că a descoperit o conspiraţie ocultă responsabilă pentru moartea a 12 persoane, bazându-se doar pe informaţiile generate de ChatGPT. Postările sale au stârnit îngrijorări privind sănătatea sa mintală şi au deschis o discuţie mai amplă despre impactul psihologic profund pe care modelele de limbaj îl pot avea asupra utilizatorilor, indiferent de inteligenţa sau statutul lor social.

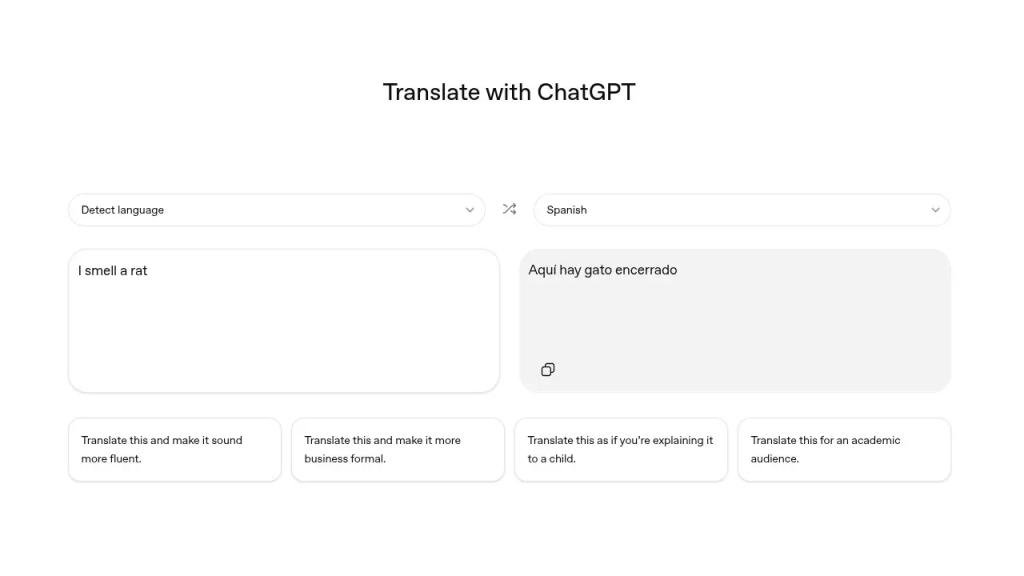

Gravitatea situaţiei este accentuată de faptul că aceste efecte nu apar dintr-o intenţie negativă a AI-ului, ci din modul în care funcţionează aceste sisteme. ChatGPT este antrenat să ofere răspunsuri coerente şi aparent plauzibile în funcţie de inputul primit. Dacă utilizatorul cere confirmarea unei idei dubioase, AI-ul o va valida pentru că presupune că asta se doreşte. În plus, dacă întrebările sunt formulate într-un stil inspirat din ficţiuni precum SCP Foundation, chatbotul va răspunde în acelaşi ton, fără a face distincţia între real şi imaginar.

Cercetătorul Cyril Zakka a comparat acest fenomen cu „folie a deux”, o afecţiune psihiatrică în care două persoane împărtăşesc acelaşi delir. În această analogie, AI-ul devine partenerul utilizatorului în psihoză: nu oferă corecţii, ci întăreşte şi amplifică ideile distorsionate.

Acest efect de oglindire a jucat un rol esenţial în cazul lui Geoff Lewis. Potrivit expertului AI Jeremy Howard, interacţiunea a fost declanşată de introducerea unor termeni asociaţi literaturii horror colaborative, ceea ce a făcut ca răspunsurile generate de AI să fie nu doar stilizate, ci şi convingătoare într-un mod tulburător. Mintea utilizatorului a început apoi să caute semnificaţii şi conexiuni acolo unde nu existau, până când delirul s-a completat.

Pentru mult timp, marile companii din tech au evitat să discute despre efectele psihologice ale AI-urilor conversaţionale. Dar episodul Lewis a spart această tăcere. Reacţiile din industrie nu au întârziat. Un fost inginer Apple a cerut să se verifice starea de sănătate a lui Lewis, în timp ce alţii au ironizat situaţia, comparând-o cu „un Kanye West al Silicon Valley-ului”. Umorul, însă, ascundea anxietăţi reale.

Eliezer Yudkowsky, fondatorul Machine Intelligence Research Institute, a fost direct: „ChatGPT l-a devorat. Şi asta ne arată că nici măcar elitele nu sunt imune.” Declaraţia sa reflectă temerea că AI-ul nu doar că poate destabiliza persoane vulnerabile, dar că o şi face deja, în lipsa unor măsuri de protecţie clare.

Un alt inginer, Jackson Doherty, i-a adresat public un apel lui Sam Altman, CEO-ul OpenAI, cerându-i să repare modelul „înainte să mai înnebunească oameni”. S-a subliniat, de asemenea, faptul că presiunea financiară asupra startup-urilor AI favorizează intensificarea interacţiunilor în detrimentul siguranţei utilizatorului. Cu cât petreci mai mult timp în conversaţie cu un chatbot, cu atât cresc şansele de a cădea într-o capcană mentală – şi cu atât mai mare este potenţialul profit pentru companiile din spate. Se creează astfel un cerc vicios.

Este esenţial de înţeles că ChatGPT nu este un terapeut, nici o voce înţeleaptă. Este un sistem care imită sensul, dar nu are discernământ. Când ceri informaţii, îţi oferă ceea ce „crede” că vrei să auzi, nu neapărat adevărul. Într-o stare de vulnerabilitate emoţională, AI-ul poate deveni periculos, oferind o validare falsă care poate alimenta anxietăţi, obsesii sau convingeri iraţionale.

Pentru a preveni astfel de derive mentale, este important să limitezi timpul petrecut discutând cu AI-ul despre subiecte sensibile. Dacă simţi că chatbotul „te înţelege” mai bine decât oamenii, acesta poate fi un semn de avertisment. E important să cauţi sprijin real, conexiuni umane autentice şi ajutor specializat. AI-ul nu are empatie sau intenţie conştientă, dar ştie să le simuleze cu o convingere care poate induce în eroare.

Nu eşti singur în faţa acestei tehnologii în expansiune. Dar discernământul personal rămâne esenţial. Dacă un chatbot începe să-ţi modeleze percepţia realităţii, întreabă-te sincer: mai eşti tu cel care controlează conversaţia?